KI-Bot „OpenClaw / Moltbot“: Hochriskante Sicherheitslücke ermöglicht Codeschmuggel

In dem KI-Bot OpenClaw, auch bekannt als Moltbot, wurde eine schwerwiegende Sicherheitslücke entdeckt, die als hochriskant eingestuft wird. Die Schwachstelle ermöglicht sogenannten Codeschmuggel in Form von Code Injection. Angreifer können manipulierten Code in Anfragen einschleusen, der von der KI verarbeitet und unter Umständen weitergegeben oder in nachgelagerten Systemen ausgeführt wird.

Technischer Hintergrund der Bedrohung:

OpenClaw beziehungsweise Moltbot ist als KI-gestützter Agent konzipiert, der mit weitreichenden Berechtigungen ausgestattet ist. Der Bot kann eigenständig Aktionen ausführen, auf Schnittstellen zugreifen und Prozesse anstoßen. Genau diese umfassenden Rechte erhöhen das Risiko erheblich. Wird die KI manipuliert, kann sie missbräuchlich als Einfallstor genutzt werden, um sicherheitskritische Abläufe zu beeinflussen oder interne Systeme zu kompromittieren.

Die identifizierte Schwachstelle beruht auf einer unzureichenden Prüfung und Absicherung von Eingaben. Dadurch ist es möglich, schädliche Inhalte so zu platzieren, dass sie von der KI als legitime Anweisung interpretiert und weiterverarbeitet werden. Besonders problematisch ist dabei, dass KI-Systeme nicht nur Befehle ausführen, sondern Inhalte kontextuell bewerten, kombinieren und weiterreichen. Klassische Schutzmechanismen greifen hier oft nicht zuverlässig.

Inhärente Risiken durch weitreichende Systemrechte:

Der Vorfall verdeutlicht ein grundsätzliches Sicherheitsproblem moderner KI-Agenten. Je mehr Autonomie und Systemrechte eine KI besitzt, desto größer ist das potenzielle Schadensausmaß bei einer erfolgreichen Manipulation. OpenClaw kann abhängig von der jeweiligen Konfiguration auf interne Dienste, Dateien oder Programmierschnittstellen zugreifen. Eine kompromittierte KI agiert damit nicht nur als passives Ziel, sondern als aktiver Akteur innerhalb der IT-Infrastruktur. Das Risiko betrifft daher nicht nur den Bot selbst, sondern alle angebundenen Systeme und automatisierten Prozesse.

Wer ist betroffen:

Betroffen sind vor allem Organisationen, Unternehmen und Entwickler:innen, die OpenClaw beziehungsweise Moltbot produktiv einsetzen oder in bestehende IT-Umgebungen integriert haben. Indirekt gefährdet sind auch Kund:innen, Nutzer:innen oder Geschäftspartner, wenn automatisierte Prozesse, Inhalte oder Entscheidungen auf Basis kompromittierter KI-Ausgaben erfolgen. Besonders kritisch ist der Einsatz in sensiblen Bereichen wie IT-Administration, Datenverarbeitung oder automatisierten Entscheidungsprozessen.

SiBa empfiehlt:

- KI-Agenten ausschließlich mit den minimal notwendigen Rechten betreiben. Das Prinzip der geringsten Privilegien sollte konsequent angewendet werden.

- Autonome KI-Systeme klar von sicherheitskritischen Kernsystemen trennen.

- Eingaben und Ausgaben von KI-Anwendungen technisch begrenzen, filtern und protokollieren.

- Regelmäßig prüfen, ob KI-Systeme mehr Berechtigungen besitzen, als für ihren Einsatzzweck erforderlich ist.

Wer kann mir helfen?

- BSI – Presse – Aktualisierte Fassung veröffentlicht: Chancen und Risiken generativer KI-Modelle

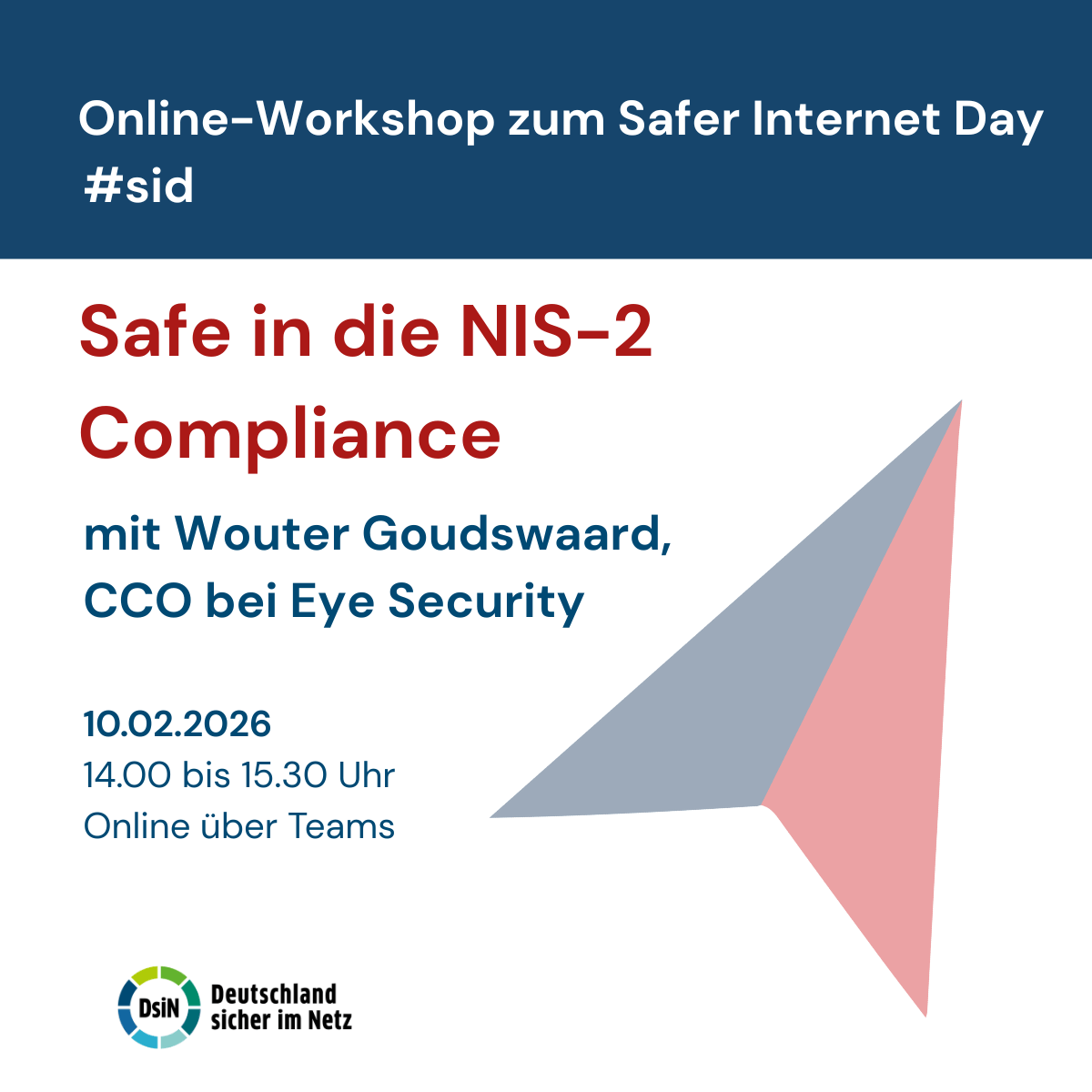

- DsiN-Angebote zum Thema „Künstliche Intelligenz“ – DSIN

Wie schütze ich mich?

- BSI – Bundesamt für Sicherheit in der Informationstechnik – Sicherer, robuster und nachvollziehbarer Einsatz von KI

- BSI – Presse – Künstliche Intelligenz sicher in Industriesteuerungen integrieren

- Künstliche Intelligenz • Digitalführerschein (DiFü)

Quelle der Meldung: heise.de

Kontaktieren Sie uns

Kontaktieren Sie uns für

Ihre Anfrage gerne unter:

(0) 30 767581-500

Presseanfragen richten

Sie bitte an:

(0) 30 767581-514

Postanschrift

Deutschland sicher im Netz e.V.

Albrechtstraße 10c 10117 Berlin